- كورسات

إدارة الأعمال

الشبكات و تكنولوجيا المعلوماتإدارة البياناتتطوير البرمجياتالتحول الرقميالتصميم و الجرافيك

- المسارات التعليمية

- تكنولوجي

إدارة الأعمال

ستساعدك هذه الدورة على فهم التقنيات الأساسية للحوسبة والتخزين التي تُستخدم لبناء حل تحليلي.

وستتعلم تقنيات الاستيعاب المختلفة التي يمكن استخدامها لتحميل البيانات باستخدام إمكانية Apache Spark الموجودة في Azure Synapse Analytics أو Azure Databricks، أو كيفية الاستيعاب باستخدام Azure Data Factory أو أنابيب Azure Synapse.

في هذه الدورة DP-203T00: هندسة البيانات على منصة Microsoft Azure سيركز الطالب على هندسة البيانات فيما يتعلق بالعمل مع حلول تحليلية دفعية وفي الوقت الحقيقي باستخدام تقنيات منصة البيانات Azure.

سيبدأ الطلاب بفهم التقنيات الأساسية للحوسبة والتخزين التي تُستخدم لبناء حلا تحليلي.

ستمكنهم الدورة من استكشاف البيانات المخزنة تفاعليًا في ملفات في بحيرة البيانات.

سيتعلمون تقنيات الاستيعاب المختلفة التي يمكن استخدامها لتحميل البيانات باستخدام إمكانية Apache Spark الموجودة في Azure Synapse Analytics أو Azure Databricks، أو كيفية الاستيعاب باستخدام Azure Data Factory أو أنابيب Azure Synapse.

سيتعلم الطلاب أيضًا الطرق المختلفة التي يمكن بها تحويل البيانات باستخدام نفس التقنيات المستخدمة لاستيعاب البيانات.

سيفهمون أهمية تنفيذ الأمان لضمان حماية البيانات في وضع الراحة أو أثناء النقل.

ثم سيعرض الطالب كيفية إنشاء نظام تحليلي في الوقت الحقيقي لإنشاء حلا تحليلي في الوقت الحقيقي.

الجمهور الرئيسي لهذه الدورة هم محترفو البيانات ومهندسو البيانات ومحترفو الذكاء الاصطناعي الذين يرغبون في التعرف على هندسة البيانات وبناء حلول تحليلية باستخدام تقنيات منصة البيانات المتاحة على منصة مايكروسوفت أزور.

والجمهور الثانوي لهذه الدورة هم محللو البيانات وعلماء البيانات الذين يعملون مع حلول تحليلية تم بناؤها على منصة مايكروسوفت أزور.

الوحدة 1: استكشاف خيارات الحوسبة والتخزين لأعباء هندسة البيانات

توفر هذه الوحدة نظرة عامة على خيارات التقنيات في Azure المتعلقة بالحوسبة والتخزين المتاحة لمهندسي البيانات الذين يقومون ببناء أعباء تحليلية.

تعلم هذه الوحدة كيفية هيكلة بحيرة البيانات وتحسين الملفات لاستكشاف البيانات، والبيانات المتدفقة، والأعباء التدفقة والدُفعة.

سيرى الطالب كيفية تنظيم بحيرة البيانات إلى مستويات تنقية البيانات عند تحويل الملفات من خلال معالجة الدفعات والتدفق.

ثم سيتعلم كيفية إنشاء فهارس على مجموعات البيانات الخاصة بهم، مثل ملفات CSV و JSON و Parquet، واستخدامها لتسريع الاستعلام والأعباء المحتملة.

الدروس

– مقدمة إلى Azure Synapse Analytics

– شرح Azure Databricks

– مقدمة إلى تخزين بحيرة بيانات Azure

– شرح هندسة بحيرة دلتا

– العمل مع تيارات البيانات باستخدام Azure Stream Analytics

– مختبر: استكشاف خيارات الحوسبة والتخزين لأعباء هندسة البيانات

– الجمع بين معالجة البيانات المتدفقة والدفعات في أنبوب واحد

– تنظيم بحيرة البيانات إلى مستويات تحويل الملف

– فهرسة تخزين بحيرة البيانات لتسريع الاستعلام والأعباء

الوحدة 2: تشغيل استعلامات تفاعلية باستخدام أحواض SQL الخادمية في Azure Synapse Analytics

في هذه الوحدة، سيتعلم الطلاب كيفية العمل مع الملفات المخزنة في بحيرة البيانات ومصادر الملفات الخارجية، من خلال تعبئة عبارات T-SQL يقوم بها حوض SQL خادمي في Azure Synapse Analytics.

سيقوم الطلاب بالاستعلام عن ملفات Parquet المخزنة في بحيرة البيانات، بالإضافة إلى ملفات CSV المخزنة في متجر بيانات خارجي.

ثم سيقومون بإنشاء مجموعات الأمان في Active Directory وفرض الوصول إلى الملفات في بحيرة البيانات من خلال التحكم في الوصول القائم على الأدوار (RBAC) وقوائم التحكم في الوصول (ACLs).

الدروس

– استكشاف قدرات أحواض SQL الخادمية في Azure Synapse

– الاستعلام عن البيانات في البحيرة باستخدام أحواض SQL خادمية في Azure Synapse

– إنشاء كائنات البيانات في أحواض SQL خادمية في Azure Synapse

– تأمين البيانات وإدارة المستخدمين في أحواض SQL خادمية في Azure Synapse

– مختبر: تشغيل استعلامات تفاعلية باستخدام أحواض SQL الخادمية

– الاستعلام عن البيانات Parquet باستخدام أحواض SQL الخادمية

– إنشاء جداول خارجية لملفات Parquet و CSV

– إنشاء عروض بمساعدة أحواض SQL الخادمية

– تأمين الوصول إلى البيانات في بحيرة البيانات عند استخدام أحواض SQL الخادمية

– تكوين أمان بحيرة البيانات باستخدام التحكم في الوصول القائم على الأدوار (RBAC) وقوائم التحكم في الوصول

الوحدة 3: استكشاف وتحويل البيانات في Azure Databricks

تعلم هذه الوحدة كيفية استخدام طرق مختلفة لتحليل وتحويل البيانات في Azure Databricks باستخدام أساليب إطار البيانات Apache Spark.

سيتعلم الطلاب كيفية أداء أساليب إطار البيانات القياسية لاستكشاف وتحويل البيانات.

سيتعلمون أيضًا كيفية أداء مهام أكثر تقدمًا، مثل إزالة البيانات المكررة، وتلاعب قيم التاريخ/الوقت، وإعادة تسمية الأعمدة، وتجميع البيانات.

الدروس

– شرح Azure Databricks

– قراءة وكتابة البيانات في Azure Databricks

– العمل مع إطارات البيانات في Azure Databricks

– العمل مع أساليب إطارات البيانات المتقدمة في Azure Databricks

– مختبر: استكشاف وتحويل البيانات في Azure Databricks

– استخدام إطارات البيانات في Azure Databricks لاستكشاف وتصفية البيانات

– تخزين إطار البيانات مؤقتًا للاستعلامات فيما بعد بشكل أسرع

– إزالة البيانات المكررة

– تلاعب بقيم التاريخ/الوقت

– إزالة وإعادة تسمية أعمدة إطار البيانات

– تجميع البيانات المخزنة في إطار البيانات

الوحدة 4: استكشاف وتحويل وتحميل البيانات إلى مستودع البيانات باستخدام Apache Spark

تعلم هذه الوحدة كيفية استكشاف البيانات المخزنة في بحيرة البيانات، وتحويل البيانات، وتحميل البيانات في مخزن البيانات العلاقي.

سيرى الطالب ملفات Parquet وJSON واستخدام تقنيات للاستعلام وتحويل ملفات JSON ذات هياكل تسلسلية.

ثم سيستخدم الطالب Apache Spark لتحميل البيانات في مستودع البيانات ودمج البيانات المخزنة في البيانات المرسلة في بحيرة البيانات مع البيانات في حوض SQL مخصص.

الوحدة الدراسية 5: استيعاب وتحميل البيانات في مستودع البيانات

تُعلم هذه الوحدة الطلاب كيفية استيعاب البيانات في مستودع البيانات باستخدام النصوص T-SQL وأنابيب تكامل Synapse Analytics.

سيتعلم الطالب كيفية تحميل البيانات في مجموعات SQL المخصصة لـ Synapse باستخدام PolyBase و COPY باستخدام T-SQL.

سيتعلم الطالب أيضًا كيفية استخدام إدارة الأعباء بالاشتراك مع نشاط النسخ في أنبوب Azure Synapse لاستيعاب البيانات بمقياس البيتابايت.

الدروس:

– استخدام أفضل ممارسات تحميل البيانات في Azure Synapse Analytics

– استيعاب بيتابايت البيانات باستخدام Azure Data Factory

– معمل: استيعاب وتحميل البيانات في مستودع البيانات

– أداء استيعاب بيتابايت البيانات باستخدام أنابيب Synapse للبيانات

– استيراد البيانات باستخدام PolyBase و COPY باستخدام T-SQL

– استخدام أفضل ممارسات تحميل البيانات في Azure Synapse Analytics

الوحدة الدراسية 6: تحويل البيانات باستخدام Azure Data Factory أو أنابيب Azure Synapse

تُعلم هذه الوحدة الطلاب كيفية بناء أنابيب تكامل البيانات لاستيعاب البيانات من مصادر بيانات متعددة، وتحويل البيانات باستخدام تدفقات البيانات الخريطية، وأداء حركة البيانات إلى واحد أو أكثر من مصارف البيانات.

الدروس:

– تكامل البيانات باستخدام Azure Data Factory أو أنابيب Azure Synapse

– تحويل بيانات بدون كود بمقياس كبير باستخدام Azure Data Factory أو أنابيب Azure Synapse

– معمل: تحويل البيانات باستخدام Azure Data Factory أو أنابيب Azure Synapse

– تنفيذ تحويلات بدون كود بمقياس كبير باستخدام أنابيب Synapse للبيانات

– إنشاء أنبوب بيانات لاستيراد ملفات CSV بتنسيق سيء

– إنشاء تدفقات بيانات الخريطة

الوحدة الدراسية 7: تنظيم حركة البيانات وتحويلها في أنابيب Azure Synapse

في هذه الوحدة، ستتعلم كيفية إنشاء خدمات مرتبطة وتنظيم حركة البيانات وتحويلها باستخدام دفاتر الملاحظات في أنابيب Azure Synapse.

الدروس:

– تنظيم حركة البيانات وتحويلها في Azure Data Factory

– معمل: تنظيم حركة البيانات وتحويلها في أنابيب Azure Synapse

– تكامل البيانات من خلال دفاتر الملاحظات مع Azure Data Factory أو أنابيب Azure Synapse

الوحدة الدراسية 8: أمان النهاية إلى النهاية مع Azure Synapse Analytics

في هذه الوحدة، سيتعلم الطلاب كيفية تأمين مساحة عمل Synapse Analytics وبنيتها التحتية المدعومة.

سيقوم الطالب بمراقبة مسؤول Active Directory SQL، وإدارة قواعد جدار الحماية لعناوين IP، وإدارة الأسرار باستخدام Azure Key Vault والوصول إلى تلك الأسرار من خلال خدمة وأنشطة الأنابيب المرتبطة بمخزن الأسرار.

سيتعلم الطالب كيفية تنفيذ الأمان على مستوى الأعمدة، والأمان على مستوى الصفوف، وإخفاء البيانات الديناميكي عند استخدام مجموعات SQL المخصصة.

الدروس:

– تأمين مستودع البيانات في Azure Synapse Analytics

– تكوين وإدارة الأسرار في Azure Key Vault

– تنفيذ ضوابط الامتثال للبيانات الحساسة

– معمل: أمان النهاية إلى النهاية مع Azure Synapse Analytics

– تأمين البنية التحتية التي تدعم Azure Synapse Analytics

– تأمين مساحة العمل Azure Synapse Analytics والخدمات المدارة المرتبطة بها

– تأمين بيانات مساحة العمل Azure Synapse Analytics

الوحدة الدراسية 9: دعم معالجة البيانات التحليلية الهجينة التحويلية والمعاملاتية (HTAP) باستخدام Azure Synapse Link

في هذه الوحدة، سيتعلم الطلاب كيف يمكن لـ Azure Synapse Link تمكين الاتصال السلس بين حساب Azure Cosmos DB ومساحة عمل Synapse.

سيفهم الطالب كيفية تمكين وتكوين Synapse Link، ثم كيفية استعلام مخزن Azure Cosmos DB التحليلي باستخدام Apache Spark و SQL serverless.

الدروس:

– تصميم معالجة بيانات تحليلية ومعاملاتية هجينة باستخدام Azure Synapse Analytics

– تكوين Synapse Link مع Azure Cosmos DB

– استعلام مخزن Azure Cosmos DB باستخدام مجموعات Apache Spark

– استعلام مخزن Azure Cosmos DB باستخدام مجموعات SQL serverless

– معمل: دعم معالجة البيانات التحليلية الهجينة التحويلية والمعاملاتية (HTAP) باستخدام Azure Synapse Link

– تكوين Synapse Link مع Azure Cosmos DB

– استعلام مخزن Azure Cosmos DB باستخدام Apache Spark لمساحة العمل Synapse Analytics

– استعلام مخزن Azure Cosmos DB باستخدام مجموعات SQL serverless لمساحة العمل Synapse Analytics

الوحدة الدراسية 10: معالجة البيانات بالوقت الحقيقي باستخدام Stream Analytics

في هذه الوحدة، سيتعلم الطلاب كيفية معالجة بيانات البث بوقت حقيقي باستخدام Stream Analytics من Azure.

سيقوم الطالب بإستيعاب بيانات تلميتر السيارة في Event Hubs، ثم معالجة تلك البيانات في الوقت الحقيقي باستخدام وظائف النوافذ المتعددة في Stream Analytics. سيتم إخراج البيانات إلى Azure Synapse Analytics.

أخيرًا، سيتعلم الطالب كيفية تكبير وظيفة Stream Analytics لزيادة الإنتاجية.

الدروس:

– تمكين الرسائل الموثوقة لتطبيقات البيانات الكبيرة باستخدام Azure Event Hubs

– العمل مع تدفقات البيانات باستخدام Azure Stream Analytics

– إستيعاب تدفقات البيانات باستخدام Azure Stream Analytics

– معمل: معالجة البيانات في الوقت الحقيقي باستخدام Stream Analytics

– استخدام Stream Analytics لمعالجة البيانات في الوقت الحقيقي من Event Hubs

– استخدام وظائف النوافذ في Stream Analytics لبناء مجموعات وإخراجها إلى Synapse Analytics

– تكبير وظيفة Azure Stream Analytics لزيادة الإنتاجية من خلال تجزئة الإدخال التدفقي

– إعادة تقسيم إدخال التدفق لتحسين التوزيع

الوحدة 11: إنشاء حلاً لمعالجة البيانات المتدفقة باستخدام Event Hubs و Azure Databricks

في هذه الوحدة، سيتعلم الطلاب كيفية استقبال ومعالجة البيانات المتدفقة بشكل كبير باستخدام Event Hubs و Spark Structured Streaming في Azure Databricks. سيتعلم الطالب ميزات واستخدامات الهياكل المنظمة في البيانات المتدفقة. سيقوم الطالب بتنفيذ نوافذ منزلقة لتجميع البيانات على شكل أجزاء وتطبيق عمليات Watermarking لإزالة البيانات القديمة. وفي النهاية، سيتصل الطالب بـ Event Hubs لقراءة وكتابة البيانات المتدفقة.

الدروس

– معالجة البيانات المتدفقة باستخدام الهياكل المنظمة في Azure Databricks

– معمل: إنشاء حلاً لمعالجة البيانات المتدفقة باستخدام Event Hubs و Azure Databricks

– استكشاف الميزات الرئيسية واستخدامات الهياكل المنظمة في البيانات المتدفقة

– تدفق البيانات من ملف وكتابتها إلى نظام ملف موزع

– استخدام نوافذ منزلقة لتجميع البيانات على شكل أجزاء بدلاً من كل البيانات

– تطبيق عمليات Watermarking لإزالة البيانات القديمة

– الاتصال بـ Event Hubs لقراءة وكتابة البيانات المتدفقة

– وصف Azure Synapse Analytics

– وصف Azure Databricks

– وصف تخزين Azure Data Lake

– وصف تركيبة Delta Lake

– وصف Azure Stream Analytics

– فهم إمكانيات أحواض SQL الخادمية في Azure Synapse

– استعلام البيانات في البحيرة باستخدام أحواض SQL الخادمية في Azure Synapse

– إنشاء كائنات البيانات الوصفية في أحواض SQL الخادمية في Azure Synapse

– تأمين البيانات وإدارة المستخدمين في أحواض SQL الخادمية في Azure Synapse

– وصف Azure Databricks

– قراءة وكتابة البيانات في Azure Databricks

– العمل مع أطُر البيانات في Azure Databricks

– العمل مع أساليب متقدمة لأطُر البيانات في Azure Databricks

– وصف هندسة البيانات الضخمة باستخدام Apache Spark في Azure Synapse Analytics

– استقبال البيانات باستخدام دفاتر ملاحظات Apache Spark في Azure Synapse Analytics

– تحويل البيانات باستخدام أطُر البيانات في حمامات Apache Spark في Azure Synapse Analytics

– دمج SQL وأحواض Apache Spark في Azure Synapse Analytics

– استخدام ممارسات تحميل البيانات الأفضل في Azure Synapse Analytics

– استقبال البيانات بمقياس البيتابايت باستخدام Azure Data Factory

– أداء تكامل البيانات باستخدام Azure Data Factory

– أداء تحويل بدون كود بمقياس كبير باستخدام Azure Data Factory

– تنظيم حركة البيانات وتحويلها في أنابيب Azure Synapse

– تأمين مستودع بيانات في Azure Synapse Analytics

– تكوين وإدارة الأسرار في Azure Key Vault

– تنفيذ ضوابط الامتثال للبيانات الحساسة

– تصميم معالجة المعاملات التحليلية الهجينة باستخدام Azure Synapse Analytics

– تكوين رابط Azure Synapse مع قاعدة بيانات Azure Cosmos DB

– استعلام قاعدة بيانات Azure Cosmos DB باستخدام Apache Spark لـ Azure Synapse Analytics

– استعلام قاعدة بيانات Azure Cosmos DB باستخدام خادم SQL بدون خادم لـ Azure Synapse Analytics

– تمكين الرسائل الموثوقة لتطبيقات البيانات الكبيرة باستخدام Azure Event Hubs

– العمل مع تيارات البيانات باستخدام Azure Stream Analytics

– استقبال تيارات البيانات باستخدام Azure Stream Analytics

– معالجة البيانات المتدفقة باستخدام هياكل البيانات المنظمة في Azure Databricks

– استكشاف خيارات الحوسبة والتخزين لأعباء هندسة البيانات في Azure

– تشغيل استعلامات تفاعلية باستخدام أحواض SQL الخادمية

– أداء استكشاف البيانات وتحويلها في Azure Databricks

– استكشاف وتحويل وتحميل البيانات إلى مستودع البيانات باستخدام Apache Spark

– استقبال وتحميل البيانات إلى مستودع البيانات

– تحويل البيانات باستخدام Azure Data Factory أو أنابيب Azure Synapse

– دمج البيانات من الملاحظات مع Azure Data Factory أو أنابيب Azure Synapse

– دعم معالجة المعاملات التحليلية الهجينة (HTAP) باستخدام رابط Azure Synapse

– تنفيذ أمان نهاية إلى نهاية باستخدام Azure Synapse Analytics

– أداء معالجة البيانات المتدفقة في الوقت الحقيقي باستخدام تحليلات البيانات المتدفقة

– إنشاء حلاً لمعالجة البيانات المتدفقة باستخدام Event Hubs و Azure Databricks

الجمهور الرئيسي لهذا الدورة هم المحترفون في مجال البيانات، ومهندسو البيانات، ومحترفو الذكاء الاصطناعي الذين يرغبون في التعرف على هندسة البيانات وبناء حلاً تحليليًا باستخدام تقنيات منصة البيانات المتوفرة على Microsoft Azure.

الجمهور الثانوي لهذا الدورة هم محللو البيانات وعلماء البيانات الذين يعملون على حلول تحليلية مبنية على Microsoft Azure.

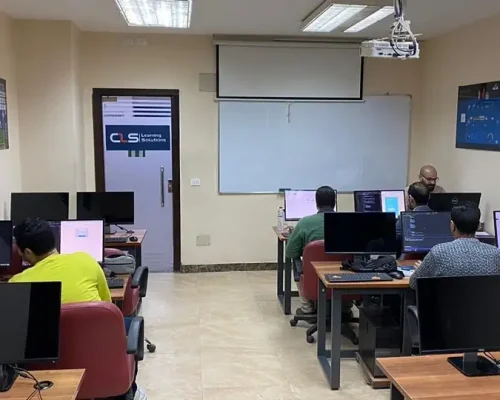

نحن في السوق منذ عام 1995، واكتسبنا خبرة واسعة في مجال التدريب، وقدمنا التدريب لأكثر من 100000 متدرب منذ ذلك الحين، في مصر، ومنطقة الشرق الأوسط وشمال إفريقيا.

قاعات CLS مجهزة تجهيزًا جيدًا بتقنيات الأجهزة والبرامج القوية التي تساعد كل من الطلاب والمدربين على قيادة برامج تدريبية فعالة وسلسة للغاية.

نقدم لعملائنا أفضل الحلول المصممة خصيصًا لتلبية احتياجاتهم وأهدافهم المحددة. فريقنا مؤهل تأهيلا عاليا للرد على أي أسئلة لديك.

CLS هي شريك معتمد من قبل قادة التكنولوجيا. وهذا يعني أن برامجنا التدريبية من أعلى مصادر الجودة.

نحن على اطلاع دائم بأي تغيير في السوق وفي مجال التكنولوجيا، لذلك ستكون برامجنا التدريبية دائمًا محدثة وفقًا لأحدث المعايير العالمية، ومواكبة لسوق العمل العالمي المتغير باستمرار.

نحن نختار أفضل المدربين، المعتمدين من شركات عالمية موثوقة. وهم يشاركون خبرتهم المهنية مع المتدربين، حتى يتمكنوا من الحصول على خبرة عملية واضحة.

أنا أحضر الآن تدريب CEH مع المهندس محمد حمدي، وتدريب CISSP مع المهندس محمد جوهر، لقد تعلمت منه الكثير حقًا، كل شيء هنا في CLS مرضي للغاية بما في ذلك الفصول الدراسية.

لقد قمنا بأخذ سلسلة من الدورات في وحدة التحول الرقمي بالوزارة. وانتهينا للتو من دورة تدريب شهادة CRISC مع الدكتور عادل عبد المنعم. شكراً لجميع جهودكم في CLS، نقدر ذلك حقًا.

أنا وزملائي نعمل في منظمة حكومية. لقد أخذنا عددًا من دورات التدريب في مجال الأمن السيبراني مع CLS، بدءًا من CEH وCISSP. وحقا أعجبنا كل شيء هنا، من المدربين إلى الموظفين والبيئة بأكملها.

أنا حاليًا أحضر دورة ASP.NET Core مع MVC مع المهندس محمد هشام. لقد تعلمت الكثير منه حقًا، وكل شيء هنا في مركز تعلم البرمجة مرضي للغاية، بما في ذلك المرافق. شكرًا لكم جميعًا.

كانت تجربة رائعة لتأهيل الكوادر في وحدات التحول الرقمي في الوكالات الحكومية التي تنتقل إلى العاصمة الإدارية، شكراً CLS .

أنا حاليًا أحضر دورة ASP.NET Core مع MVC مع المهندس محمد هشام. كانت تجربة تعليمية مختلفة، وكل شيء هنا في CLS مفيد ومبهج للغاية، بما في ذلك المرافق. شكرًا لكم جميعًا.

أنا حاليًا أحضر دورة تدريب شهادة CRISC مع الدكتور عادل عبد المنعم. لقد تعلمت الكثير منه حقًا، وكل شيء هنا في CLS جميل للغاية، بما في ذلك المرافق والمواقع والفريق.

أنا حاليًا أحضر دورة ASP.NET Core مع MVC مع المهندس محمد هشام. وأضاف لي الكثير، وكل مراحل الدورة في CLSكانت مفيدة ومليئة بالخبرات، شكرًا لمجهوداتكم وإخلاصكم.

استفد من كل لحظة، تعلم مع CLS، مركز التدريب المصنف كأفضل مركز تدريب في مصر منذ عام 1995، 28 عامًا من الخبرة في تدريب الشركات والأفراد في مصر ومنطقة الشرق الأوسط وشمال أفريقيا.

© 2026 - CLS لحلول التعليم | جميع الحقوق محفوظة.